Zrozumienie podstaw NLP dla chatbotów

Zanim zagłębimy się w techniczne aspekty szkolenia chatbotów, ważne jest, aby zrozumieć podstawowe koncepcje NLP, które napędzają nowoczesną konwersacyjną sztuczną inteligencję. Podstawy te stanowią fundament, na którym budowane są naprawdę pomocne i responsywne chatboty.

Kluczowe komponenty NLP dla chatbotów

Dobrze zaprojektowany chatbot NLP opiera się na kilku krytycznych komponentach działających w harmonii:

- Rozpoznawanie intencji – identyfikacja tego, co użytkownik próbuje osiągnąć (np. rezerwacja spotkania, prośba o informacje, zgłoszenie problemu).

- Ekstrakcja jednostek – pobieranie określonych informacji z danych wprowadzanych przez użytkownika (nazwy, daty, lokalizacje, typy produktów).

- Zarządzanie kontekstem – utrzymywanie historii konwersacji w celu dostarczania kontekstowych odpowiedzi

- Analiza nastrojów – określanie emocji użytkownika w celu odpowiedniego dostosowania odpowiedzi

- Zrozumienie języka – zrozumienie znaczenia komunikatów użytkownika pomimo różnic w sformułowaniach.

Każdy z tych elementów wymaga określonych podejść szkoleniowych i danych, współpracujących ze sobą w celu stworzenia spójnego doświadczenia konwersacyjnego.

Zaawansowane platformy sztucznej inteligencji, takie jak Gibion, mogą pomóc usprawnić wdrażanie tych komponentów w architekturze chatbota.

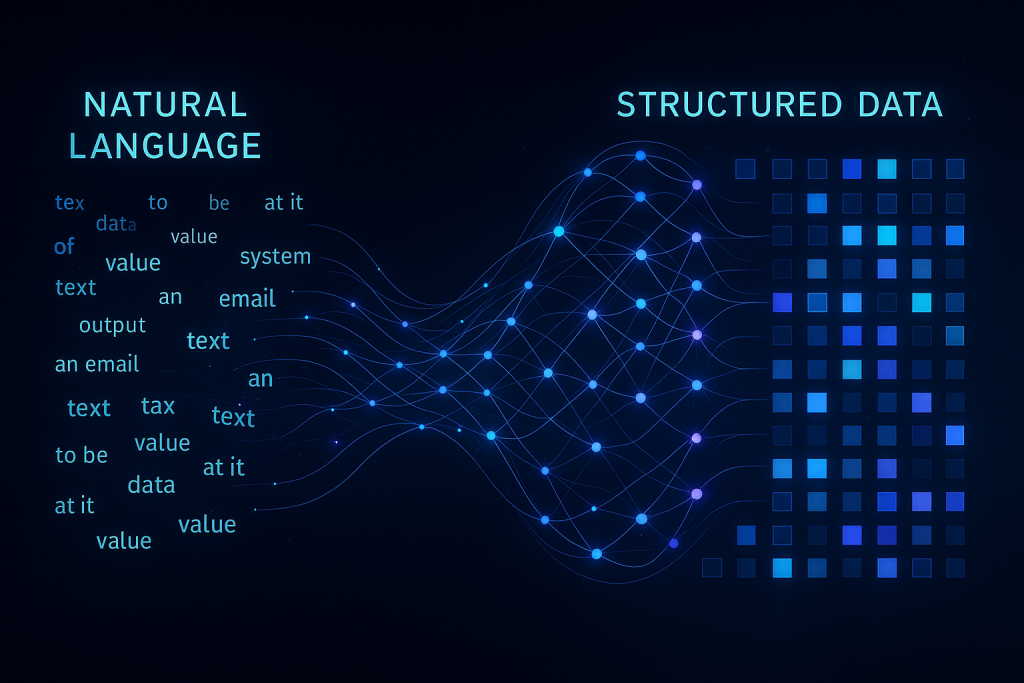

Jak NLP przekształca tekst w użyteczne dane

Magia NLP ma miejsce, gdy surowy tekst jest przetwarzany przez kilka warstw lingwistycznych:

| Warstwa przetwarzania |

Funkcja |

Przykład |

| Tokenizacja |

Dzielenie tekstu na słowa lub podsłowa |

„Muszę przełożyć” → [„ja”, „muszę”, „do”, „przełożyć”] |

| Tagowanie części mowy |

Identyfikacja elementów gramatycznych |

„Zarezerwuj spotkanie” → [Czasownik, Artykuł, Rzeczownik] |

| Parsowanie zależności |

Ustalanie relacji między słowami |

Określenie „jutro” modyfikuje „spotkanie” w „zaplanuj spotkanie na jutro” |

| Rozpoznawanie encji nazwanych |

Identyfikacja określonych typów jednostek |

Rozpoznawanie „21 maja” jako daty i „sali konferencyjnej A” jako lokalizacji |

| Analiza semantyczna |

Zrozumienie znaczenia i intencji |

Rozpoznanie „Czy możesz przesunąć moją godzinę 14:00?” jako prośby o zmianę harmonogramu |

Ten potok przetwarzania językowego przekształca nieustrukturyzowane dane wejściowe w ustrukturyzowane dane, na których chatboty mogą działać, co stanowi różnicę między botem, który jedynie odpowiada, a takim, który naprawdę rozumie.

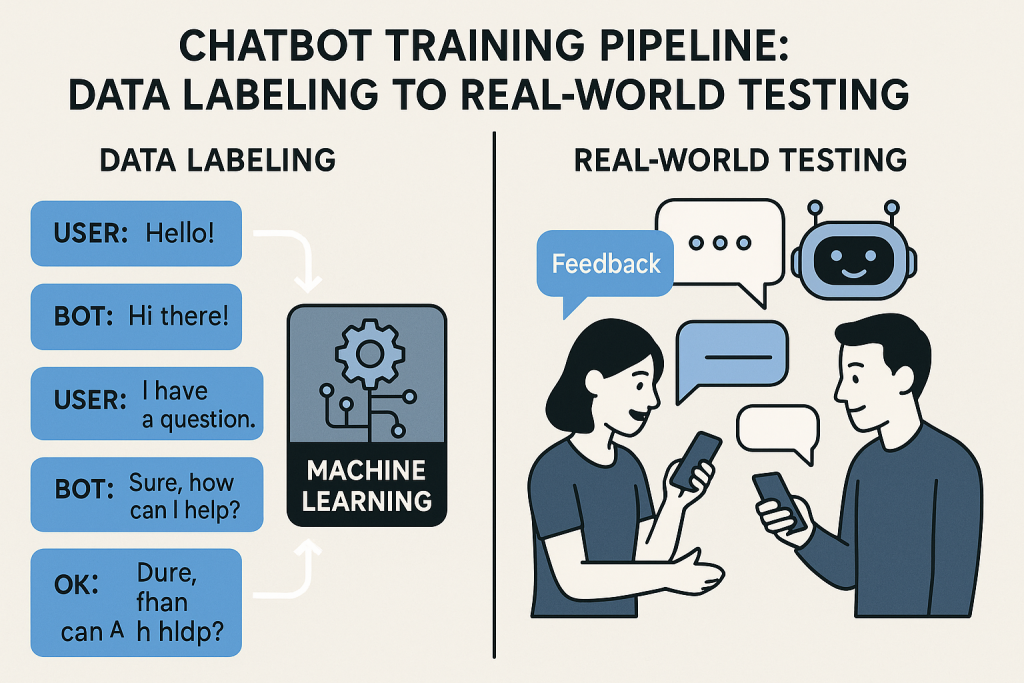

Gromadzenie danych i przygotowanie do szkolenia

Jakość danych treningowych ma bezpośredni wpływ na wydajność chatbota. Ta kluczowa podstawa decyduje o tym, czy bot zrozumie użytkowników, czy też pozostawi ich sfrustrowanych.

Tworzenie zróżnicowanego zestawu danych szkoleniowych

Skuteczny chatbot NLP potrzebuje ekspozycji na szeroką gamę sposobów, w jakie użytkownicy mogą wyrażać tę samą intencję. Oto jak zbudować kompleksowy zbiór danych:

- Metody zbierania zapytań użytkowników

- Analiza dzienników obsługi klienta i transkrypcji czatów

- Przeprowadzanie wywiadów z użytkownikami i grup fokusowych

- Wdrożenie testów beta z udziałem prawdziwych użytkowników

- Przegląd forów branżowych i mediów społecznościowych

- Mapowanie przepływu konwersacji – tworzenie wykresów typowych ścieżek konwersacji, jakie mogą obrać użytkownicy.

- Techniki wariacji zapytań – generowanie alternatywnych sformułowań dla każdej intencji

- Terminologia specyficzna dla danej dziedziny – obejmuje żargon branżowy i specjalistyczne słownictwo.

- Najlepsze praktyki w zakresie adnotacji danych – spójne oznaczanie danych za pomocą jasnych wytycznych

Pamiętaj, że twój chatbot będzie tylko tak dobry, jak różnorodność przykładów, na które jest narażony podczas szkolenia. Zróżnicowany zbiór danych pomaga upewnić się, że bot poradzi sobie z nieprzewidywalnością rozmów w świecie rzeczywistym.

Techniki czyszczenia i wstępnego przetwarzania danych

Surowe dane konwersacyjne są nieuporządkowane. Oto jak je udoskonalić, aby uzyskać optymalne wyniki szkolenia:

- Normalizacja tekstu – konwersja całego tekstu na małe litery, spójna obsługa znaków interpunkcyjnych

- Obsługa błędów ortograficznych – Uwzględnianie typowych literówek i błędów autokorekty

- Usuwanie szumów – filtrowanie nieistotnych informacji i słów wypełniających.

- Radzenie sobie ze slangiem i skrótami – w tym skrótami konwersacyjnymi, takimi jak „omg” lub „asap”.

- Rozszerzanie danych – tworzenie dodatkowych ważnych przykładów szkoleniowych poprzez kontrolowane wariacje

Ten proces czyszczenia przekształca surowe, niespójne dane w ustrukturyzowany format, z którego model może skutecznie się uczyć.

Korzystanie ze wstępnie zdefiniowanych szablonów może pomóc usprawnić ten proces, szczególnie w przypadku typowych przypadków użycia.

Wybór odpowiedniej architektury modelu NLP

Nie wszystkie modele NLP są sobie równe, a wybór odpowiedniej architektury dla konkretnych potrzeb ma kluczowe znaczenie dla sukcesu chatbota.

Podejścia oparte na regułach a uczenie maszynowe

Istnieje kilka różnych podejść do zasilania rozumienia chatbota:

| Podejście |

mocne strony |

ograniczenia |

Najlepsze dla |

| Oparte na regułach |

Przewidywalne zachowanie, łatwiejsze debugowanie, działa z ograniczonymi danymi |

Sztywne, nie radzi sobie z nieoczekiwanymi danymi wejściowymi, wymaga dużo pracy przy utrzymaniu |

Proste przypadki użycia o ograniczonym zakresie, branże podlegające ścisłym regulacjom |

| Statystyczne ML |

Lepsza generalizacja, obsługa wariantów, ulepsza się wraz z większą ilością danych |

Wymaga znacznej ilości danych treningowych, okazjonalne nieoczekiwane zachowanie |

Przypadki użycia o średniej złożoności z umiarkowaną dostępnością danych |

| Hybrydowe |

Łączy przewidywalność z elastycznością, mechanizmy awaryjne |

Bardziej złożone we wdrożeniu, wymaga starannej integracji |

Złożone domeny z pewnymi krytycznymi ścieżkami wymagającymi pewności |

Wiele udanych wdrożeń rozpoczyna się od podejścia hybrydowego, wykorzystując reguły dla krytycznych funkcji, jednocześnie wykorzystując uczenie maszynowe do ogólnej obsługi konwersacji.

Modele głębokiego uczenia dla zaawansowanego zrozumienia

W przypadku zaawansowanych aplikacji chatbot, modele głębokiego uczenia oferują bezprecedensowe możliwości rozumienia języka:

- Architektury transformatorowe – podstawa nowoczesnego NLP, umożliwiająca zwracanie uwagi na różne części tekstu wejściowego.

- Implementacje BERT i GPT – Wstępnie wytrenowane modele, które przechwytują głęboką wiedzę lingwistyczną

- Dostrajanie wstępnie wytrenowanych modeli – Dostosowywanie istniejących modeli do konkretnej domeny

- Tworzenie niestandardowych modeli – tworzenie wyspecjalizowanych architektur dla unikalnych wymagań

- Wymagania dotyczące zasobów – równoważenie złożoności modelu z dostępnymi zasobami obliczeniowymi

Podczas gdy większe modele, takie jak GPT, mogą zapewnić imponujące wyniki, często wymagają znacznych zasobów. W przypadku wielu aplikacji biznesowych mniejsze, precyzyjnie dostrojone modele zapewniają najlepszą równowagę między wydajnością a efektywnością.