Capire i fondamenti del NLP per i chatbot

Prima di tuffarti negli aspetti tecnici dell’addestramento dei chatbot, è essenziale afferrare i concetti base del NLP che alimentano l’IA conversazionale moderna. Questi fondamenti formano la base su cui si costruiscono chatbot veramente utili e reattivi.

Componenti chiave del NLP per i chatbot

Un chatbot NLP ben progettato si basa su diversi componenti critici che lavorano in armonia:

- Riconoscimento dell’intento – Identificare cosa l’utente sta cercando di fare (es. prenotare un incontro, chiedere informazioni, segnalare un problema)

- Estrazione di entità – Estrarre pezzi specifici di informazione dagli input degli utenti (nomi, date, luoghi, tipi di prodotti)

- Gestione del contesto – Mantenere la cronologia della conversazione per fornire risposte contestualmente rilevanti

- Analisi del sentimento – Determinare le emozioni dell’utente per adattare le risposte di conseguenza

- Comprensione del linguaggio – Capire il significato dietro i messaggi degli utenti nonostante le variazioni nella formulazione

Ognuno di questi elementi richiede approcci di addestramento e dati specifici, lavorando insieme per creare un’esperienza conversazionale coesa.

Piattaforme AI avanzate come Gibion possono aiutare a semplificare l’implementazione di questi componenti nella tua architettura chatbot.

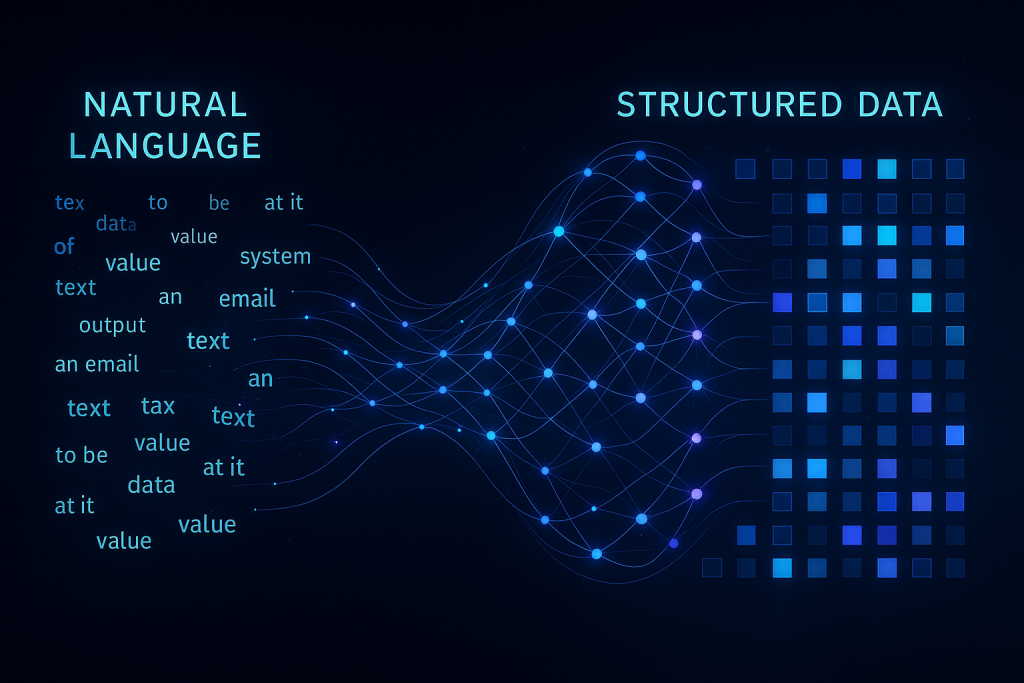

Come il NLP trasforma il testo in dati utilizzabili

La magia del NLP avviene quando il testo grezzo viene elaborato attraverso diversi strati linguistici:

| Strato di elaborazione |

funzione |

esempio |

| Tokenizzazione |

Suddividere il testo in parole o parti di parole |

“Devo riprogrammare” → [“Devo”, “ri”, “programmare”] |

| Etichettatura grammaticale |

Identificare gli elementi grammaticali |

“Prenota un incontro” → [Verbo, Articolo, Sostantivo] |

| Analisi delle dipendenze |

Stabilire relazioni tra le parole |

Determinare che “domani” modifica “incontro” in “programma un incontro domani” |

| Riconoscimento di entità nominate |

Identificare tipi di entità specifici |

Riconoscere “21 maggio” come una data e “Sala Conferenze A” come un luogo |

| Analisi semantica |

Capire il significato e l’intento |

Riconoscere “Puoi spostare il mio appuntamento delle 14?” come una richiesta di riprogrammazione |

Questa pipeline di elaborazione linguistica trasforma gli input di testo non strutturati in dati strutturati su cui i chatbot possono agire, facendo la differenza tra un bot che si limita a rispondere e uno che capisce davvero.

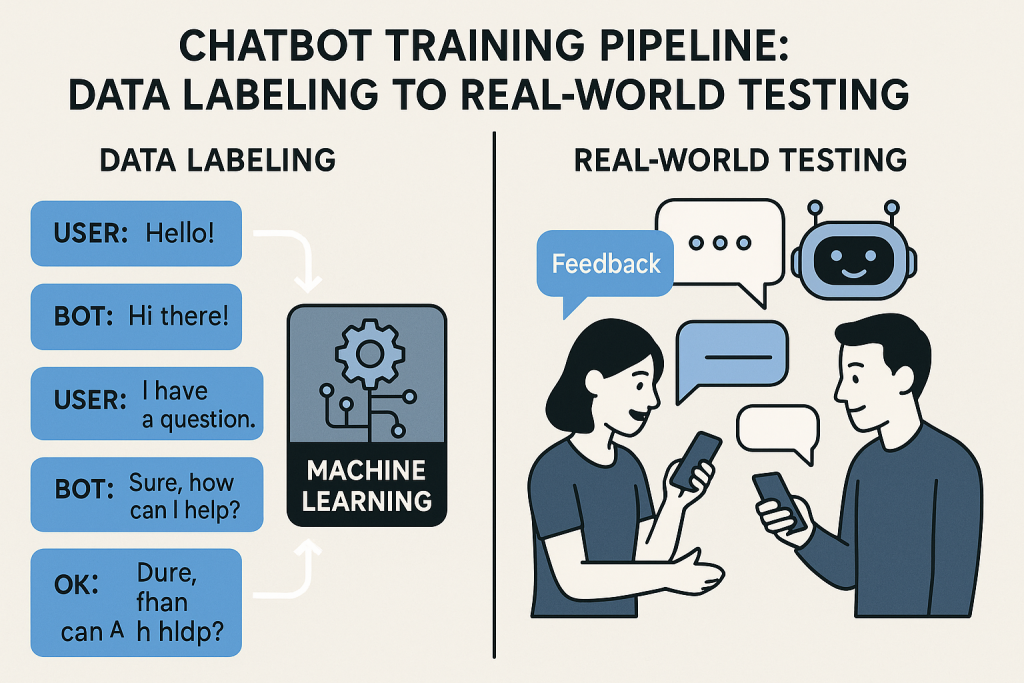

Raccolta e preparazione dei dati per l’addestramento

La qualità dei tuoi dati di addestramento influenza direttamente le prestazioni del tuo chatbot. Questa base cruciale determina se il tuo bot capirà gli utenti o li lascerà frustrati.

Creare un set di dati di addestramento diversificato

Un chatbot NLP efficace ha bisogno di essere esposto alla grande varietà di modi in cui gli utenti potrebbero esprimere lo stesso intento. Ecco come costruire un set di dati completo:

- Metodi di raccolta delle query degli utenti

- Analizza i log del supporto clienti e le trascrizioni delle chat

- Conduci interviste agli utenti e gruppi di discussione

- Implementa test beta con utenti reali

- Esamina forum specifici del settore e social media

- Mappatura del flusso di conversazione – Traccia i percorsi di conversazione tipici che gli utenti potrebbero seguire

- Tecniche di variazione delle query – Genera formulazioni alternative per ogni intento

- Terminologia specifica del dominio – Includi gergo del settore e vocabolario specializzato

- Migliori pratiche di annotazione dei dati – Etichetta i dati in modo coerente con linee guida chiare

Ricorda, il tuo chatbot sarà buono solo quanto la varietà di esempi a cui è esposto durante l’addestramento. Un dataset diversificato aiuta a garantire che il tuo bot possa gestire l’imprevedibilità delle conversazioni reali.

Tecniche di pulizia e pre-elaborazione dei dati

I dati grezzi delle conversazioni sono disordinati. Ecco come raffinarli per risultati di addestramento ottimali:

- Normalizzazione del testo – Convertire tutto il testo in minuscolo, gestire la punteggiatura in modo coerente

- Gestione degli errori di ortografia – Incorporare errori di battitura comuni e correzioni automatiche

- Rimozione del rumore – Filtrare informazioni irrilevanti e parole di riempimento

- Gestione di slang e abbreviazioni – Includere scorciatoie conversazionali come “omg” o “asap”

- Aumento dei dati – Creare ulteriori esempi di addestramento validi attraverso variazioni controllate

Questo processo di pulizia trasforma dati grezzi e incoerenti in un formato strutturato da cui il tuo modello può imparare efficacemente.

L’uso di modelli predefiniti può aiutare a semplificare questo processo, soprattutto per i casi d’uso comuni.

Scegliere l’architettura del modello NLP giusta

Non tutti i modelli NLP sono creati uguali, e selezionare l’architettura giusta per le tue esigenze specifiche è cruciale per il successo del chatbot.

Approcci basati su regole vs. apprendimento automatico

Ci sono diversi approcci distinti per alimentare la comprensione del tuo chatbot:

| Approccio |

punti di forza |

limitazioni |

Ideale per |

| Basato su regole |

Comportamento prevedibile, più facile da debuggare, funziona con dati limitati |

Rigido, non gestisce input inattesi, richiede molta manutenzione |

Casi d’uso semplici con ambito limitato, settori altamente regolamentati |

| ML statistico |

Migliore generalizzazione, gestisce le variazioni, migliora con più dati |

Richiede dati di training sostanziosi, comportamento occasionale inatteso |

Casi d’uso di media complessità con disponibilità di dati moderata |

| Ibrido |

Combina prevedibilità e flessibilità, meccanismi di fallback |

Più complesso da implementare, richiede un’attenta integrazione |

Domini complessi con alcuni percorsi critici che richiedono certezza |

Molte implementazioni di successo iniziano con un approccio ibrido, usando regole per funzioni critiche mentre sfruttano l’apprendimento automatico per la gestione generale della conversazione.

Modelli di deep learning per comprensione avanzata

Per applicazioni chatbot sofisticate, i modelli di deep learning offrono capacità di comprensione del linguaggio senza precedenti:

- Architetture Transformer – La base dell’NLP moderno, che permette l’attenzione a diverse parti del testo in input

- Implementazioni BERT e GPT – Modelli pre-addestrati che catturano conoscenze linguistiche profonde

- Fine-tuning di modelli pre-addestrati – Adattare modelli esistenti al tuo dominio specifico

- Sviluppo di modelli personalizzati – Costruire architetture specializzate per requisiti unici

- Requisiti di risorse – Bilanciare la complessità del modello con le risorse di calcolo disponibili

Mentre modelli più grandi come GPT possono fornire risultati impressionanti, spesso richiedono risorse significative. Per molte applicazioni aziendali, modelli più piccoli e ottimizzati forniscono il miglior equilibrio tra prestazioni ed efficienza.