Comprendre les fondamentaux du NLP pour les chatbots

Avant de plonger dans les aspects techniques de la formation des chatbots, il est essentiel de saisir les concepts fondamentaux du NLP qui alimentent l’IA conversationnelle moderne. Ces fondamentaux constituent la base sur laquelle sont construits des chatbots véritablement utiles et réactifs.

Composants clés du NLP pour les chatbots

Un chatbot NLP bien conçu repose sur plusieurs composants critiques fonctionnant en harmonie :

- Reconnaissance d’intention – Identifier ce que l’utilisateur essaie d’accomplir (par exemple, réserver une réunion, demander des informations, signaler un problème)

- Extraction d’entités – Extraire des informations spécifiques des entrées utilisateur (noms, dates, lieux, types de produits)

- Gestion du contexte – Maintenir l’historique de la conversation pour fournir des réponses contextuellement pertinentes

- Analyse des sentiments – Déterminer les émotions de l’utilisateur pour adapter les réponses en conséquence

- Compréhension du langage – Saisir le sens des messages de l’utilisateur malgré les variations de formulation

Chacun de ces éléments nécessite des approches et des données de formation spécifiques, travaillant ensemble pour créer une expérience conversationnelle cohérente.

Des plateformes d’IA avancées comme Gibion peuvent aider à rationaliser l’implémentation de ces composants dans votre architecture de chatbot.

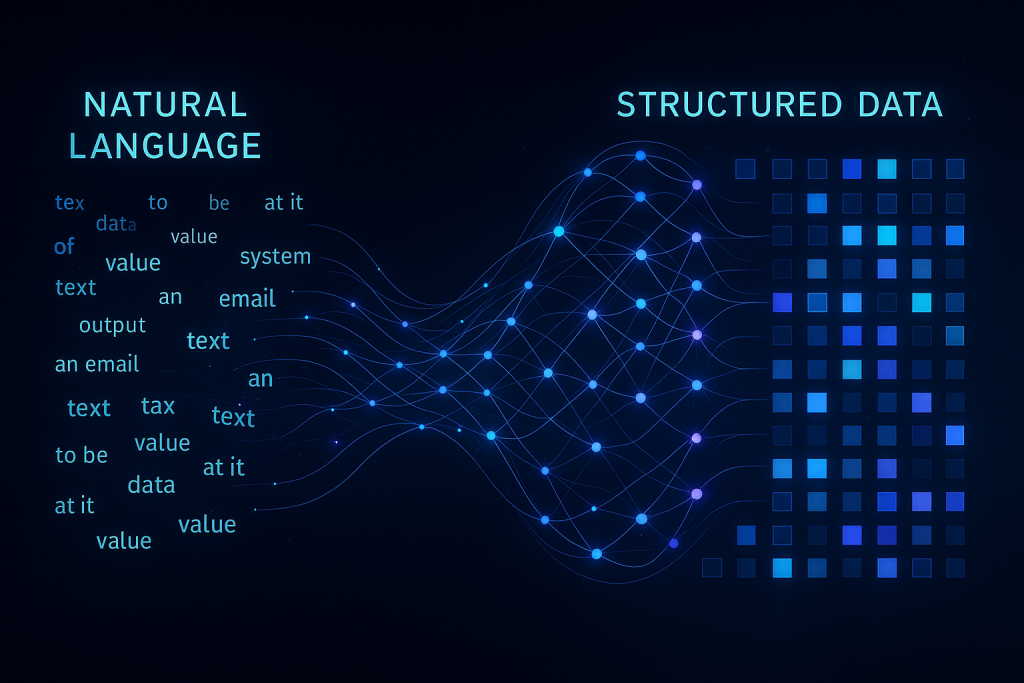

Comment le NLP transforme le texte en données exploitables

La magie du NLP se produit lorsque le texte brut est traité à travers plusieurs couches linguistiques :

| Couche de traitement |

fonction |

exemple |

TokenisationDécomposition du texte en mots ou sous-mots« J’ai besoin de reprogrammer » → [« J’ », « ai », « besoin », « de », « reprogrammer »]

| Étiquetage morpho-syntaxique |

Identification des éléments grammaticaux |

« Réserver une réunion » → [Verbe, Article, Nom] |

| Analyse des dépendances |

Établir des relations entre les mots |

Déterminer que « demain » modifie « réunion » dans « programmer une réunion demain » |

| Reconnaissance d’entités nommées |

Identifier des types d’entités spécifiques |

Reconnaître « 21 mai » comme une date et « Salle de conférence A » comme un lieu |

| Analyse sémantique |

Comprendre le sens et l’intention |

Reconnaître « Pouvez-vous déplacer mon rendez-vous de 14h ? » comme une demande de reprogrammation |

Ce pipeline de traitement linguistique transforme les entrées de texte non structurées en données structurées sur lesquelles les chatbots peuvent agir, faisant la différence entre un bot qui se contente de répondre et un bot qui comprend véritablement.

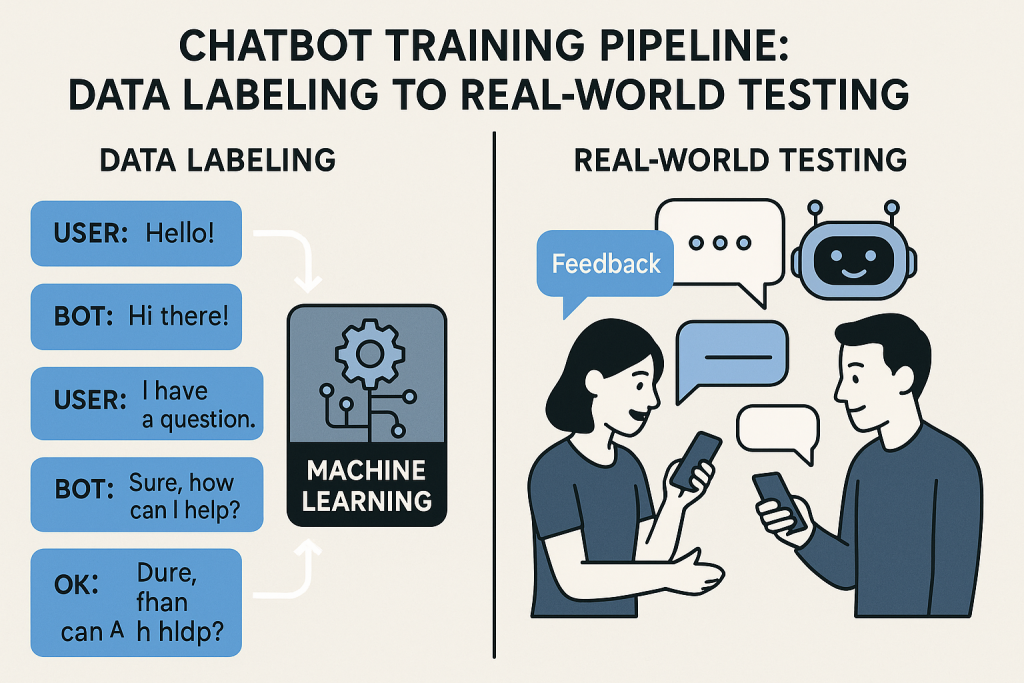

Collecte et préparation des données pour la formation

La qualité de vos données d’entraînement impacte directement les performances de votre chatbot. Cette base cruciale détermine si votre bot comprendra les utilisateurs ou les laissera frustrés.

Création d’un ensemble de données d’entraînement diversifié

Un chatbot NLP efficace nécessite une exposition à la grande variété de façons dont les utilisateurs pourraient exprimer la même intention. Voici comment construire un ensemble de données complet :

- Méthodes de collecte des requêtes utilisateurs

- Analyser les journaux de support client et les transcriptions de chat

- Mener des entretiens avec les utilisateurs et des groupes de discussion

- Mettre en œuvre des tests bêta avec de véritables utilisateurs

- Examiner les forums spécifiques à l’industrie et les médias sociaux

- Cartographie du flux de conversation – Schématiser les parcours de conversation typiques que les utilisateurs pourraient emprunter

- Techniques de variation des requêtes – Générer des formulations alternatives pour chaque intention

- Terminologie spécifique au domaine – Inclure le jargon industriel et le vocabulaire spécialisé

- Meilleures pratiques d’annotation des données – Étiqueter les données de manière cohérente avec des directives claires

Il convient de noter que votre agent conversationnel ne sera que aussi performant que la diversité des exemples auxquels il aura été exposé durant son entraînement. Un ensemble de données varié contribue à garantir que votre agent puisse gérer l’imprévisibilité des conversations du monde réel.

Techniques de nettoyage et de prétraitement des données

Les données conversationnelles brutes sont désordonnées. Voici comment les affiner pour obtenir des résultats d’entraînement optimaux :

- Normalisation du texte – Conversion de tout le texte en minuscules, traitement cohérent de la ponctuation

- Gestion des fautes d’orthographe – Incorporation des erreurs typographiques courantes et des erreurs de correction automatique

- Suppression du bruit – Filtrage des informations non pertinentes et des mots de remplissage

- Traitement de l’argot et des abréviations – Inclusion des raccourcis conversationnels tels que « omg » ou « asap »

- Augmentation des données – Création d’exemples d’entraînement supplémentaires valides par le biais de variations contrôlées

Ce processus de nettoyage transforme des données brutes et incohérentes en un format structuré à partir duquel votre modèle peut efficacement apprendre.

L’utilisation de modèles prédéfinis peut contribuer à rationaliser ce processus, en particulier pour les cas d’utilisation courants.

Sélection de l’architecture de modèle NLP appropriée

Tous les modèles NLP ne sont pas créés égaux, et la sélection de l’architecture adéquate pour vos besoins spécifiques est cruciale pour le succès de l’agent conversationnel.

Approches basées sur des règles vs. approches d’apprentissage automatique

Il existe plusieurs approches distinctes pour alimenter la compréhension de votre agent conversationnel :

| Approche |

points forts |

limitations |

Idéal pour |

| Basé sur des règles |

Comportement prévisible, plus facile à déboguer, fonctionne avec des données limitées |

Rigide, ne peut pas gérer les entrées inattendues, maintenance lourde |

Cas d’utilisation simples avec une portée limitée, industries hautement réglementées |

| ML statistique |

Meilleure généralisation, gère les variations, s’améliore avec plus de données |

Nécessite des données d’entraînement substantielles, comportement parfois inattendu |

Cas d’utilisation de complexité moyenne avec disponibilité modérée des données |

| Hybride |

Combine prévisibilité et flexibilité, mécanismes de repli |

Plus complexe à mettre en œuvre, nécessite une intégration minutieuse |

Domaines complexes avec certains chemins critiques nécessitant de la certitude |

De nombreuses implémentations réussies commencent par une approche hybride, utilisant des règles pour les fonctions critiques tout en tirant parti de l’apprentissage automatique pour la gestion générale des conversations.

Modèles d’apprentissage profond pour une compréhension avancée

Pour des applications d’agents conversationnels sophistiquées, les modèles d’apprentissage profond offrent des capacités de compréhension du langage sans précédent :

- Architectures de transformateurs – Le fondement du NLP moderne, permettant l’attention à différentes parties du texte d’entrée

- Implémentations BERT et GPT – Modèles pré-entraînés qui capturent une connaissance linguistique profonde

- Ajustement fin des modèles pré-entraînés – Adaptation des modèles existants à votre domaine spécifique

- Développement de modèles personnalisés – Construction d’architectures spécialisées pour des exigences uniques

- Exigences en ressources – Équilibrage entre la complexité du modèle et les ressources informatiques disponibles

Bien que les modèles plus volumineux comme GPT puissent fournir des résultats impressionnants, ils nécessitent souvent des ressources significatives. Pour de nombreuses applications commerciales, des modèles plus petits ajustés offrent le meilleur équilibre entre performance et efficacité.