Verständnis der NLP-Grundlagen für Chatbots

Bevor man sich in die technischen Aspekte des Chatbot-Trainings vertieft, ist es essenziell, die grundlegenden NLP-Konzepte zu erfassen, die moderne Konversations-KI antreiben. Diese Grundlagen bilden das Fundament, auf dem wirklich hilfreiche und reaktionsfähige Chatbots aufgebaut werden.

Zentrale NLP-Komponenten für Chatbots

Ein gut konzipierter NLP-Chatbot basiert auf mehreren kritischen Komponenten, die harmonisch zusammenarbeiten:

- Intentionserkennung – Identifizierung dessen, was der Benutzer zu erreichen versucht (z.B. Terminvereinbarung, Informationsanfrage, Problemmeldung)

- Entitätsextraktion – Extraktion spezifischer Informationen aus Benutzereingaben (Namen, Daten, Orte, Produkttypen)

- Kontextverwaltung – Aufrechterhaltung des Gesprächsverlaufs, um kontextuell relevante Antworten zu liefern

- Stimmungsanalyse – Bestimmung der Benutzeremotionen zur Anpassung der Antworten

- Sprachverständnis – Erfassung der Bedeutung hinter Benutzernachrichten trotz Variationen in der Formulierung

Jedes dieser Elemente erfordert spezifische Trainingsansätze und Daten, die zusammenarbeiten, um ein kohärentes Konversationserlebnis zu schaffen.

Fortschrittliche KI-Plattformen wie Gibion können die Implementierung dieser Komponenten in Ihre Chatbot-Architektur rationalisieren.

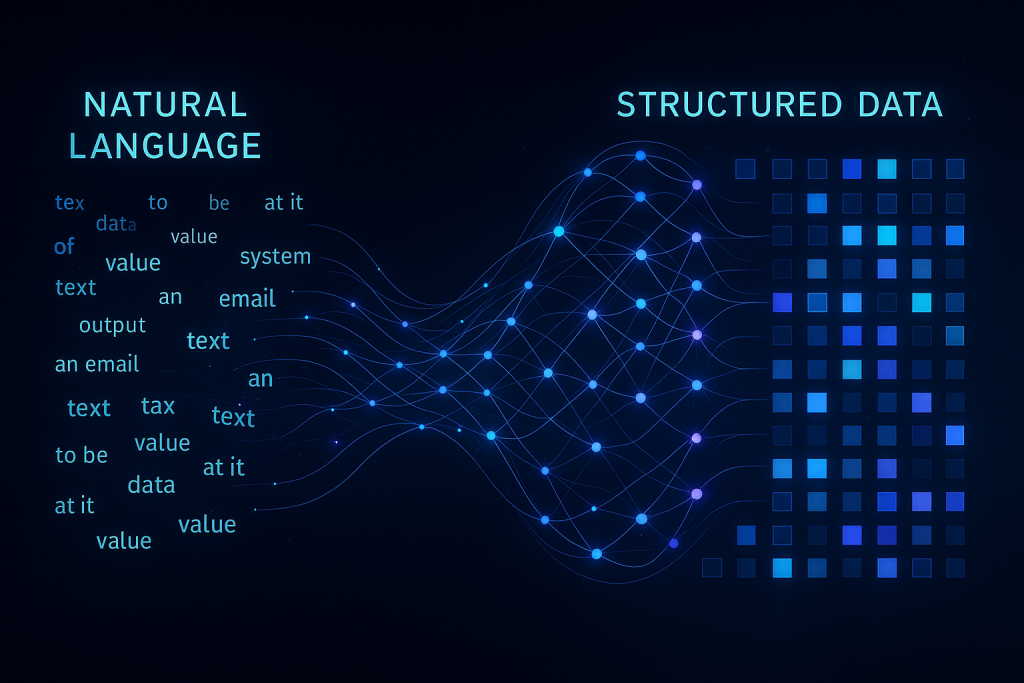

Wie NLP Text in verwertbare Daten umwandelt

Die Magie von NLP entfaltet sich, wenn Rohtext durch mehrere linguistische Schichten verarbeitet wird:

| Verarbeitungsschicht |

Funktion |

Beispiel |

| Tokenisierung |

Zerlegung von Text in Wörter oder Teilwörter |

„Ich muss umplanen“ → [„Ich“, „muss“, „um“, „planen“] |

| Wortartmarkierung |

Identifizierung grammatikalischer Elemente |

„Buche ein Meeting“ → [Verb, Artikel, Substantiv] |

| Abhängigkeitsanalyse |

Etablierung von Beziehungen zwischen Wörtern |

Bestimmung, dass „morgen“ „Meeting“ in „plane ein Meeting für morgen“ modifiziert |

| Eigennamenerkennung |

Identifizierung spezifischer Entitätstypen |

Erkennung von „21. Mai“ als Datum und „Konferenzraum A“ als Ort |

| Semantische Analyse |

Verständnis von Bedeutung und Intention |

Erkennung von „Können Sie meinen Termin um 14 Uhr verschieben?“ als Umplanungsanfrage |

Diese linguistische Verarbeitungspipeline transformiert unstrukturierte Texteingaben in strukturierte Daten, auf deren Grundlage Chatbots agieren können, was den Unterschied zwischen einem Bot ausmacht, der lediglich antwortet, und einem, der wirklich versteht.

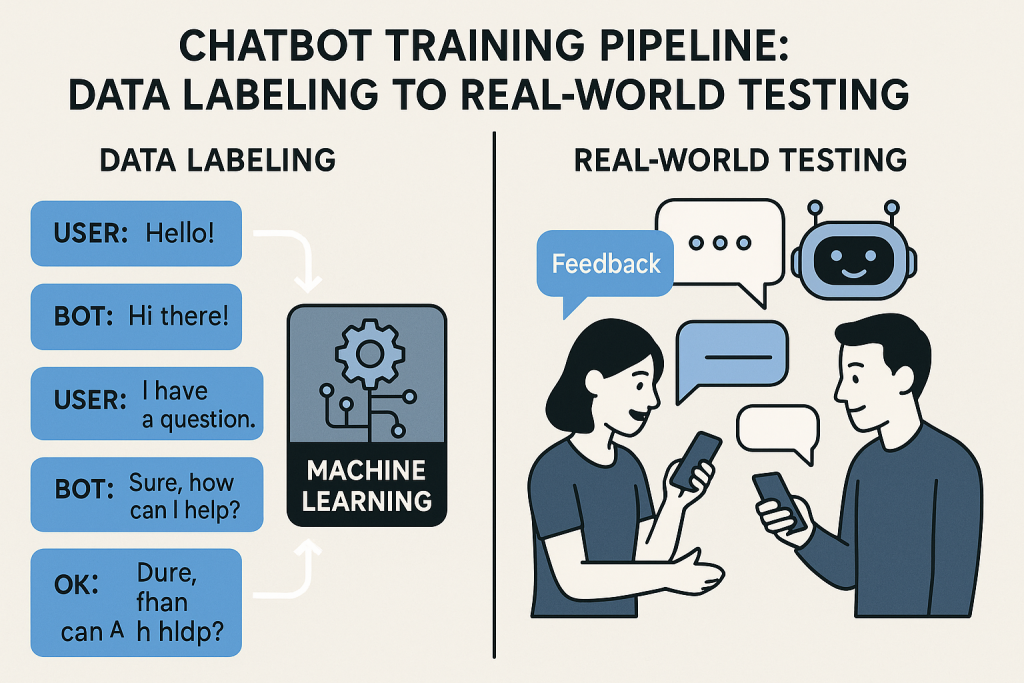

Datenerfassung und -vorbereitung für das Training

Die Qualität Ihrer Trainingsdaten beeinflusst direkt die Leistung Ihres Chatbots. Diese entscheidende Grundlage bestimmt, ob Ihr Bot Benutzer versteht oder sie frustriert zurücklässt.

Erstellung eines vielfältigen Trainingsdatensatzes

Ein effektiver NLP-Chatbot benötigt Exposition gegenüber der breiten Vielfalt von Möglichkeiten, wie Benutzer dieselbe Absicht ausdrücken könnten. Hier erfahren Sie, wie Sie einen umfassenden Datensatz aufbauen:

- Methoden zur Erfassung von Benutzeranfragen

- Analysieren Sie Kundensupport-Protokolle und Chat-Transkripte

- Durchführen von Benutzerinterviews und Fokusgruppen

- Implementierung von Beta-Tests mit realen Nutzern

- Überprüfung branchenspezifischer Foren und sozialer Medien

- Gesprächsfluss-Kartierung – Typische Gesprächsverläufe, die Benutzer einschlagen könnten, grafisch darstellen

- Abfragevariationstechniken – Alternative Formulierungen für jede Intention generieren

- Domänenspezifische Terminologie – Branchenjargon und Fachvokabular einbeziehen

- Bewährte Praktiken der Datenannotation – Daten konsistent mit klaren Richtlinien kennzeichnen

Es ist zu beachten, dass die Qualität Ihres Chatbots maßgeblich von der Vielfalt der Beispiele abhängt, denen er während des Trainings ausgesetzt ist. Ein diversifizierter Datensatz trägt dazu bei, dass Ihr Bot mit der Unvorhersehbarkeit realer Gespräche umgehen kann.

Techniken zur Datenbereinigung und -vorverarbeitung

Rohe Gesprächsdaten sind unstrukturiert. Hier erfahren Sie, wie Sie diese für optimale Trainingsergebnisse aufbereiten:

- Textnormalisierung – Konvertierung aller Texte in Kleinbuchstaben, konsistente Behandlung von Interpunktion

- Umgang mit Rechtschreibfehlern – Berücksichtigung häufiger Tippfehler und Autokorrektur-Irrtümer

- Entfernung von Störfaktoren – Filterung irrelevanter Informationen und Füllwörter

- Umgang mit Umgangssprache und Abkürzungen – Einbeziehung umgangssprachlicher Kürzel wie „omg“ oder „asap“

- Datenaugmentation – Erstellung zusätzlicher valider Trainingsbeispiele durch kontrollierte Variationen

Dieser Bereinigungsprozess transformiert rohe, inkonsistente Daten in ein strukturiertes Format, aus dem Ihr Modell effektiv lernen kann.

Die Verwendung vordefinierter Vorlagen kann dazu beitragen, diesen Prozess zu optimieren, insbesondere für häufige Anwendungsfälle.

Auswahl der geeigneten NLP-Modellarchitektur

Nicht alle NLP-Modelle sind gleichwertig, und die Auswahl der richtigen Architektur für Ihre spezifischen Anforderungen ist entscheidend für den Erfolg des Chatbots.

Regelbasierte vs. maschinelle Lernansätze

Es gibt mehrere unterschiedliche Ansätze zur Steuerung des Verständnisses Ihres Chatbots:

| Ansatz |

Stärken |

Einschränkungen |

Am besten geeignet für |

| Regelbasiert |

Vorhersehbares Verhalten, leichter zu debuggen, funktioniert mit begrenzten Daten |

Starr, kann unerwartete Eingaben nicht verarbeiten, wartungsintensiv |

Einfache Anwendungsfälle mit begrenztem Umfang, stark regulierte Branchen |

| Statistisches ML |

Bessere Generalisierung, verarbeitet Variationen, verbessert sich mit mehr Daten |

Erfordert umfangreiche Trainingsdaten, gelegentlich unerwartetes Verhalten |

Mittelschwere Anwendungsfälle mit moderater Datenverfügbarkeit |

| Hybrid |

Kombiniert Vorhersehbarkeit mit Flexibilität, Fallback-Mechanismen |

Komplexer in der Implementierung, erfordert sorgfältige Integration |

Komplexe Domänen mit einigen kritischen Pfaden, die Sicherheit erfordern |

Viele erfolgreiche Implementierungen beginnen mit einem hybriden Ansatz, der Regeln für kritische Funktionen verwendet und maschinelles Lernen für die allgemeine Gesprächsführung nutzt.

Deep-Learning-Modelle für fortgeschrittenes Verständnis

Für anspruchsvolle Chatbot-Anwendungen bieten Deep-Learning-Modelle beispiellose Fähigkeiten zum Sprachverständnis:

- Transformer-Architekturen – Das Fundament des modernen NLP, ermöglicht Aufmerksamkeit auf verschiedene Teile des Eingabetextes

- BERT- und GPT-Implementierungen – Vortrainierte Modelle, die tiefes linguistisches Wissen erfassen

- Feinabstimmung vortrainierter Modelle – Anpassung existierender Modelle an Ihre spezifische Domäne

- Entwicklung benutzerdefinierter Modelle – Erstellung spezialisierter Architekturen für einzigartige Anforderungen

- Ressourcenanforderungen – Ausbalancierung von Modellkomplexität und verfügbaren Rechenressourcen

Während größere Modelle wie GPT beeindruckende Ergebnisse liefern können, erfordern sie oft erhebliche Ressourcen. Für viele geschäftliche Anwendungen bieten kleinere, feinabgestimmte Modelle das beste Gleichgewicht zwischen Leistung und Effizienz.